“Los datos están sucios”

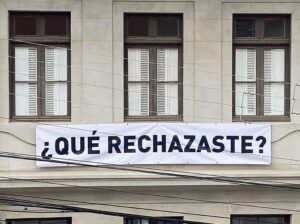

La expresión que titula este artículo es de Meredith Broussard, una periodista especializada en manejo de datos que, en el debate en torno al poder y los límites morales del big data, se ubica entre medio de quienes creen que se trata de un nuevo paraíso en la Tierra (Yuval Noah Harari) y quienes plantean que sería una nueva versión del panóptico de Bentham (Byung Chul–Han). Los datos –archivados, ordenados, procesados– siguen siendo entregados por “personas que van y cuentan cosas”, es decir, producto de intereses, afectos y voluntades que nada tienen que ver con la asepsia que supuestamente distinguiría a la máquina.

por Ricardo Martínez–Gamboa I 18 Noviembre 2020

Sugerencias de Spotify de música que debes escuchar si escuchas esta otra, y de Amazon de libros por leer si lees estos otros; avisos de rutas menos congestionadas desde Waze; pronósticos de las acciones que más subirán en la bolsa; perspectivas para tu banco de si puedes hacerte cargo de ese crédito. Todos estos son casos en que los algoritmos, el big data y el machine learning controlan la vida de millones de consumidores y ciudadanos, rutinas que facilitan la vida y que están llenas de amenazas. El “dataísmo”, que es como se ha llamado a esta tendencia, ha recibido atención de mind pundits (un término que denomina a los nuevos gurús de la sociedad del conocimiento) a lo largo de los últimos cinco años. Algunos de ellos felicitan el arribo de una era post-humana, otros se resienten ante la pérdida de la privacidad, pero es indiscutible que los datos se han transformado en el pilar de la actividad económica, política y social.

Y el ganador del Oscar es…

Cada inicio de año, las casas de apuestas del mundo se llenan de predicciones sobre quiénes se llevarán el Oscar a mejor película, director, actor y actriz. Detrás de cada click, en dichas casas de apuestas miles de críticos de home theater se las rebuscan para dar con la fórmula que les permita acertar a los ganadores. Algunos de ellos simplemente tratan de atinar solo por una cosa de olfato, pero otros mastican con sus computadoras miles de antecedentes para realizar el apronte. Es el caso de Iain Pardoe y Dean K. Simonton, quienes desde 2005 vienen prediciendo estos cuatro resultados casi con canasta completa. Entre 2008 y 2010 lograron acertar en las cuatro categorías sin fallas, lo mismo en 2013 y 2014. ¿Cómo lo hicieron?

Con una planilla Excel.

En ella introdujeron información de todas las películas, directores, actores y actrices desde que se entrega el Oscar (1928), considerando diversas variables, como nominaciones en años previos. Luego corrieron decenas de rutinas de machine learning, para ver cómo ajustaban los datos a los resultados históricos y llegaron a un algoritmo preciso, donde combinando las variables y asignándoles pesos específicos podían dar con los ganadores.

Ejercicios como el que realizaron estos investigadores se llevan a cabo en diversos ámbitos de la toma de decisiones. Se trata de un “problema de clasificación”. Un problema de clasificación consiste en que, frente a un evento, por medio de procedimientos de aprendizaje de máquina, se asigne ese evento a una categoría. Por ejemplo, determinar si una foto corresponde a un gato o a un perro.

Los problemas de clasificación permiten asignar categorías y hacer predicciones. Por ejemplo, determinar quiénes son potenciales candidatos a perder el año en la universidad o, quizá lo más atractivo, qué equipos triunfarán en el fútbol (lo que hacía el recordado “Mago de la Polla Gol”) o qué acciones de la bolsa subirán y bajarán.

Disponer de herramientas que permitan clasificar posibilita a quienes las manejan adelantarse al futuro. Y para hacerse de esta bola de cristal se necesitan básicamente tres elementos: 1) muchos datos (big data); 2) rutinas algorítmicas que permitan “masticar” esos datos; y 3) información sobre el comportamiento previo de lo que se está analizando (aunque este último elemento no es siempre necesario).

Como los datos son lo más importante –en términos del valor de la información–, las empresas tecnológicas están siempre recabando data. Así ha surgido una nueva clase social, a la que algunos denominan “jornaleros digitales”: personas que trabajan etiquetando fotos en categorías (esto es un perro, esto es un gato), clasificando textos académicos como papers, tomando muestras. Una vez que se ha levantado el big data a partir del trabajo de los jornaleros, basta con pasar por la máquina la información y ver qué sucede. Así, por ejemplo, Jacob Jolij, de la Universidad de Groningen, dio con la lista definitiva de los temas del pop más subidores de ánimo, o sitios web que pronostican cada semana qué equipos del fútbol americano (NFL) ganarán sus partidos.

Roy Amara, cofundador del Instituto para el Futuro de Palo Alto, acuñó un lema que hoy se conoce como la ‘Ley de Amara’: ‘Tendemos a sobrestimar el efecto de una tecnología a corto plazo y a subestimar el efecto a largo plazo’.

Tres posturas

Ante este arribo del “dataísmo” han surgido básicamente tres posturas. Una que dice que no, una que dice que sí y una que dice quizás.

Por la postura que dice que no, en primera línea está Byung Chul–Han, el filósofo surcoreano que en su libro Psicopolítica plantea que la obsesión y el prurito por compartir los datos personales, desde fotos hasta los más secretos pensamientos, ha abierto un ala nueva a la dominación del neoliberalismo, que expande las ideas de Foucault de una biopolítica hacia el ámbito psicológico. Chul–Han sostiene que los datos somos nosotros y que las empresas tecnológicas disponen de un “panóptico digital” que permite, por ejemplo, que Facebook te recomiende un vuelo a las Bahamas luego de que escribiste que te gustaría ir de vacaciones a ese lugar cinco minutos antes. Se trata de una mirada muy pesimista respecto de esta intromisión.

A la vanguardia de la postura que dice que sí se encuentra el historiador israelí Yuval Noah Harari, quien en 21 lecciones para el siglo XXI señala con mucho optimismo que “un conductor que predice las intenciones de un peatón, un banquero que evalúa la credibilidad de un prestatario potencial y un abogado que calibra el estado de ánimo en la mesa de negociación, no hacen uso de la brujería. Por el contrario, y aunque no lo sepan, el cerebro de cada uno de ellos reconoce patrones bioquímicos al analizar expresiones faciales, tonos de voz, gestos de las manos e incluso olores corporales. Una IA (Inteligencia Artificial) equipada con los sensores adecuados podría hacer todo eso de manera mucho más precisa y fiable que un humano”. Y aunque en el balance final Harari es más bien cauteloso, a lo largo del volumen se deja percibir una exacerbación de los milagros de la Inteligencia Artificial, el machine learning y el big data.

Por la postura del quizás se encuentra Meredith Broussard, una periodista especialista en manejo de datos, quien en Artificial Unintelligence echa paños fríos sobre las exageraciones de las posturas del sí y del no. Broussard sostiene –en su caso desde dentro de la línea de trabajo en estos temas algorítmicos– que hay mucho de fantasía, tanto desde el neo–ludismo que vaticina una especie de Skynet (el súpercomputador que controla todo en las películas de Terminator) tecnológico, como de los integrados que pronostican el paraíso en la Tierra del big data. Para ello acuña el término “tecnochovinismo”, que define como “la idea de que todos los problemas de la humanidad se pueden resolver mediante la tecnología y en especial mediante los computadores”.

¿Por qué Broussard resulta menos extrema que Chul–Han y Harari? Porque esos ingentes datos que “mastican” las máquinas digitales son facturados por seres humanos que tienen falencias: “Aquí hay un secreto a voces del mundo del big data: todos los datos están sucios. Todos ellos. Los datos son elaborados por personas que van y cuentan cosas, o por sensores que son hechos por personas. En cada columna aparentemente ordenada de números, hay ruido. (…) El problema es que los datos sucios no se computan. Por lo tanto, en el aprendizaje automático, a veces tenemos que hacer cosas para que las funciones se ejecuten sin problemas. ¿Estás horrorizado ahora? Yo lo estaba la primera vez que me di cuenta de esto. Como periodista, no puedo hacer nada. Necesito revisar cada línea y justificarla por un verificador de hechos, (…) pero en el aprendizaje automático, la gente a menudo inventa cosas cuando es conveniente”.

La postura de Broussard pone paños fríos a las perspectivas algo más extremas tanto del neo–ludismo como de los integrados, y en esto es conveniente detenerse un poco. Hace un tiempo visitó Chile el académico francés Antoine Compagnon, quien ha dedicado una vida desde el Collège de France a indagar cómo los avances tecnológicos han modificado las formas de crear y comunicar, sobre todo lo que refiere a la escritura y la lectura. Avances tan aparentemente sencillos como la invención de la pluma estilográfica a inicios del siglo XIX, significaron un cambio en la manera en que las escritoras y los escritores pasaban sus ideas al papel: el proceso era más rápido que cuando se ocupaba la pluma de ganso. Escritores franceses como Baudelaire o Flaubert siguieron usando este último instrumento por décadas; el impacto de la estilográfica solo se dio muy paulatinamente.

Roy Amara, cofundador del Instituto para el Futuro de Palo Alto, acuñó un lema que hoy se conoce como la “Ley de Amara”: “Tendemos a sobrestimar el efecto de una tecnología a corto plazo y a subestimar el efecto a largo plazo”. Cuando aparece una nueva tecnología, con apariencia revolucionaria, se ensayan muchas lecturas del impacto inmediato que ellas van a tener. Estas apreciaciones suelen ser exageradas, tanto desde el neo–ludismo como desde el lado de los integrados. Conforme avanzan las décadas, sin embargo, los efectos de dichas tecnologías se revelan como más profundos e intensos de lo que se pensó en un primer momento. Ese es el caso, muy probablemente, del big data.